Ja, hva er egentlig greia med 深度求索, eller DeepSeek som vi gjerne kaller det i vår del av verden?

DeepSeek er et kinesisk selskap som utvikler store språkmodeller (LLM-er). De påstår at de har utviklet sine modeller på kortere tid, og med langt mindre ressurser, enn tilsvarende modeller fra OpenAI. Dette har gjort at NVIDIA (som lager maskinvare som brukes under trening og kjøring av språkmodeller) stuper på børsen, og enkelte sier til og med at DeepSeek nå har revolusjonert hele AI-feltet.

De siste dagene har det også vært litt oppstyr fordi OpenAI beskylder DeepSeek for å ha brukt output fra ChatGPT for å forbedre sine modeller, noe som strider med bruksvilkårene til ChatGPT.

Lytt gjerne til Norges mest profilerte AI-forsker, Inga Strümke, som oppsummer greia med DeepSeek – og svarer på om DeepSeek faktisk har revolusjonert hele AI-feltet.

Hvis du velger å bruke online-versjonen av DeepSeek, bør du kanskje tenke deg om én gang til. Online-varianten har sensur innebygget, og hva skjer egentlig med dataene du sender inn? Jeg vet ikke...

Til forskjell fra OpenAI sine modeller er DeepSeek sine modeller open-source, så du kan kjøre de helt offline på din egen maskinvare, helt fritt for sensur og uten innsyn fra kinesiske myndigheter! Og det beste av alt: det er super-enkelt! Jeg viser tre ulike måter det kan gjøres på.

Det er verdt å merke seg at ChatGPT er litt bedre på norsk språk enn DeepSeek. Jeg har flere ganger opplevd at svarene kommer på en underlig kombinasjon av bokmål, nynorsk, svensk og dansk – og enkelte uttrykk på både engelsk og kinesisk kan også forekomme, spesielt på de minste modellene.

Ollama – fra kommandolinjen

Ollama er et verktøy som lar deg kjøre ulike typer språkmodeller fra kommandolinjen, og finnes for både Windows, Linux og MacOS.

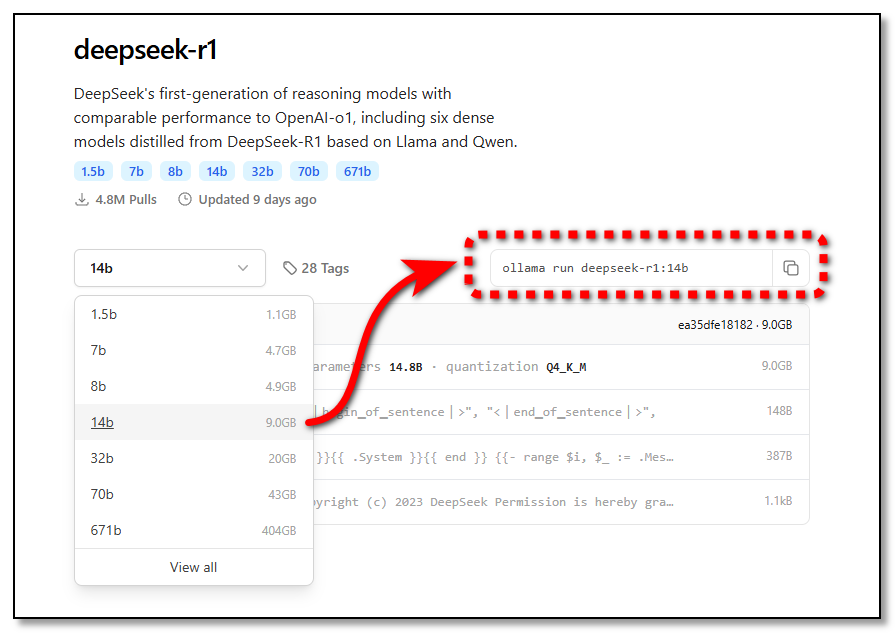

Du kan laste ned språkmodeller fra kjente tjenester som 🤗Hugging Face (der du også finner en rekke norske modeller), eller det aller enkleste er å velge en modell fra Ollama sitt rikholdige bibliotek.

Jeg finner frem til DeepSeek R1 og velger en «distilled» modell av størrelse som passer meg. Jo større modell jo bedre svar, men jo tregere i bruk. Hvis du har et kraftig grafikkkort (GPU), bør du velge en modell som får plass i GPU-en VRAM, for best ytelse.

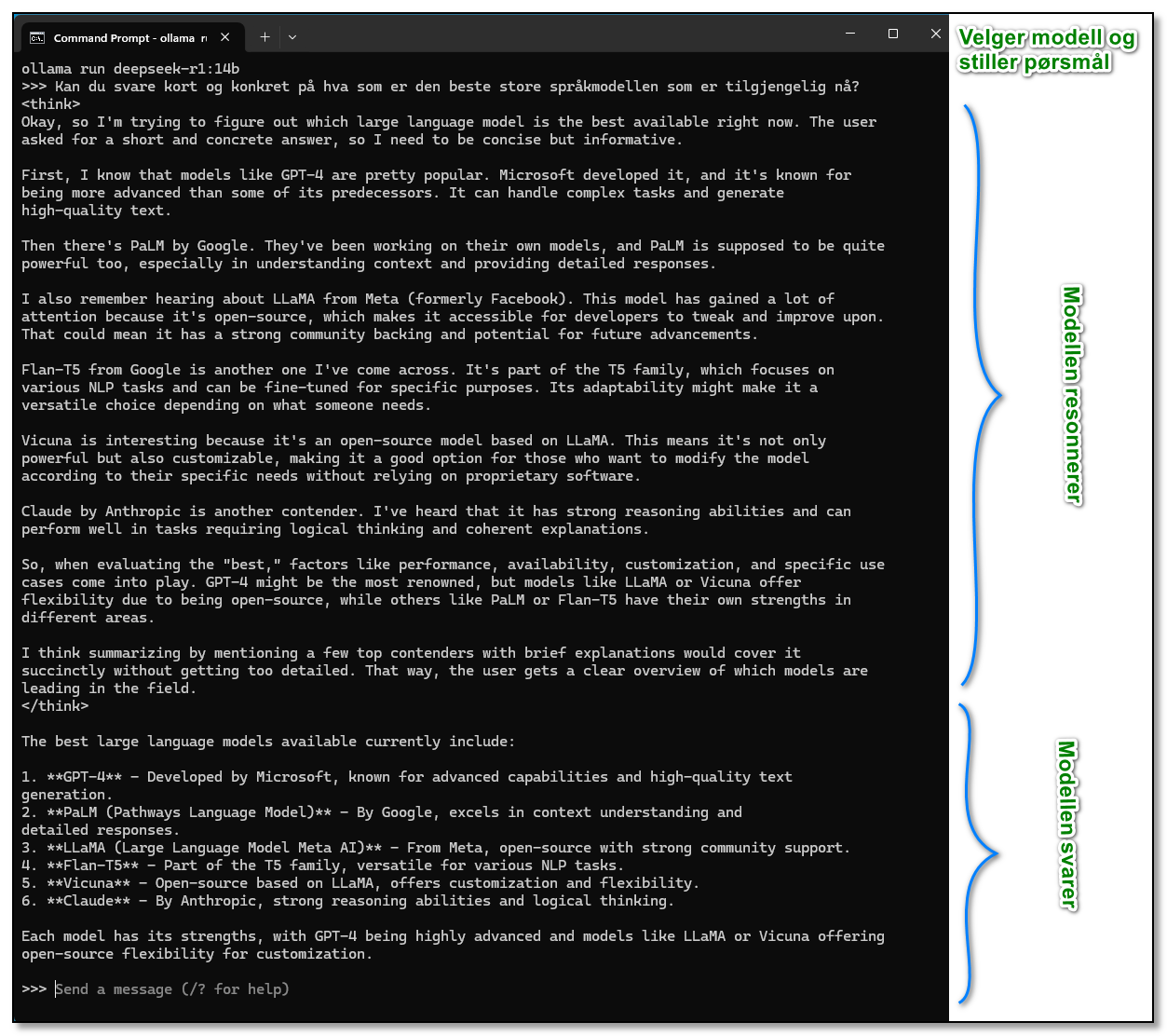

Bare kopier ollama-kommandoen og kjør den fra kommandolinjen. Modellen lastes ned første gang du kjører den, og vil deretter være klar til bruk.

DeepSeek liker å «tenke seg grundig om» før den svarer og som du ser på skjermbildet over er det meste av teksten som kommer tilbake «resonneringen» før den kommer frem til det endelige svaret.

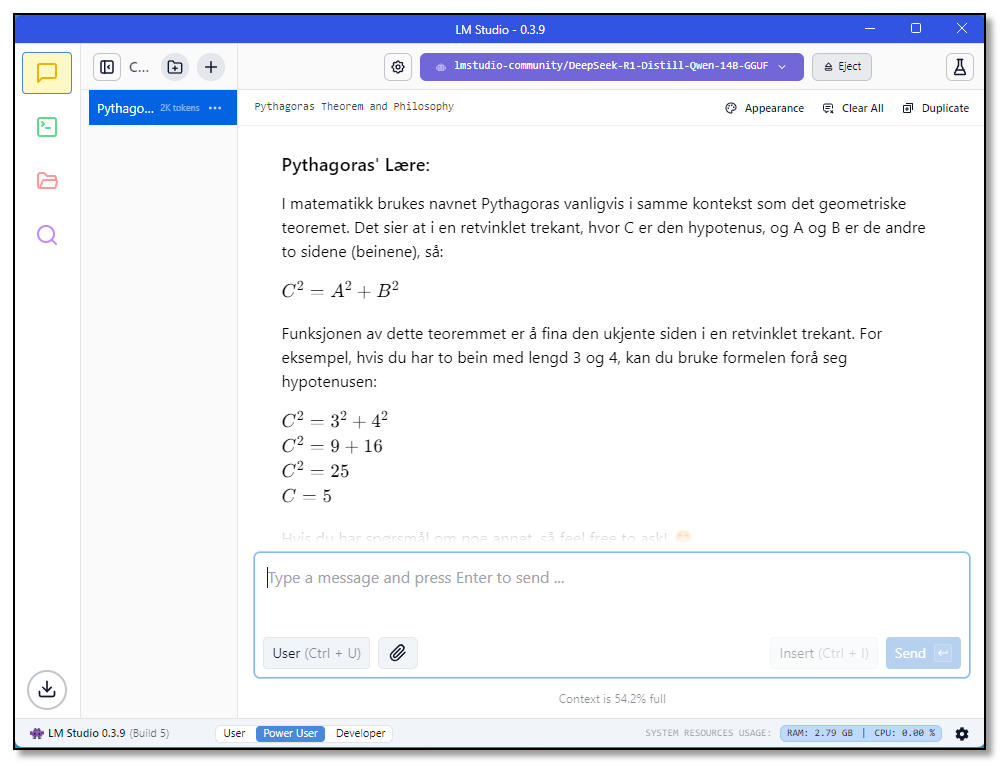

LM Studio – mer brukervennlig

Det finnes mange muligheter for å kjøre DeepSeek-modellene med et grafisk brukergrensesnitt, og LM Studio er en av disse. LM Studio finnes også for både Windows, Linux, og MacOS.

Bare installer programmet og velg ønsket modell fra biblioteket, så kan du bruke modellen med et brukergrensesnitt som minner litt om ChatGPT.

Du kan også kjøre en lokal server, for å få tilgang til språkmodellen fra et API som minner om OpenAI sine API-er.

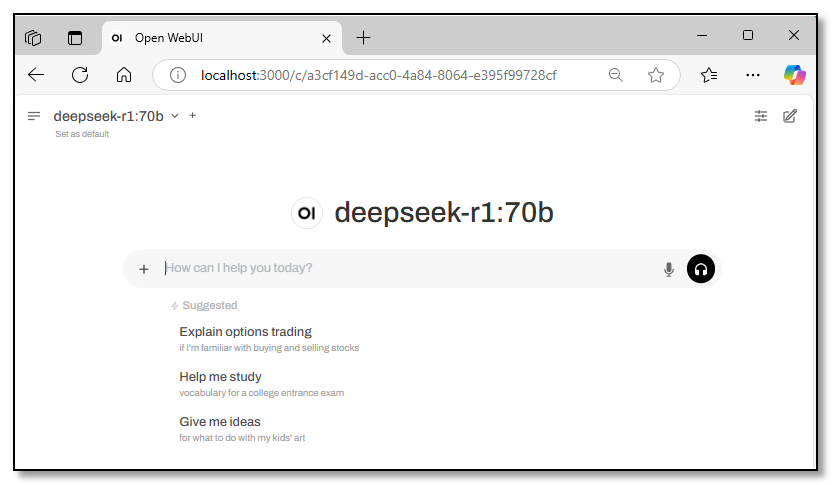

Open WebUI – rett i browseren

En ulempe med LM Studio som vist over, er at hvis du vil bruke den samme modellen både fra kommandolinjen (med Ollama) og fra et brukergrensesnitt, må du laste ned den samme modellen to ganger.

Med Open WebUI unngår du det, siden Open WebUI automatisk plukker opp alle modeller du har installert i Ollama og gir deg et velkjent web-grensesnitt.

Bare installer Docker Desktop, og kjør deretter følgende fra kommandolinjen:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainHent deg en kopp kaffe, og vipps kan du kjøre alle dine Ollama-språkmodeller rett i nettleseren!

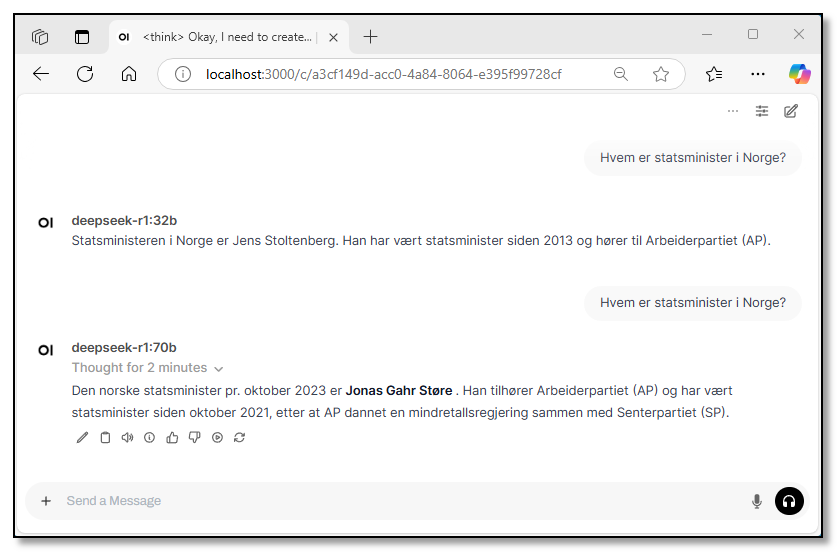

Her er et eksempel som viser hvordan de to variantene med henholdsvis 32 og 70 milliarder parametre gir ulike svar.

Der 32B-varianten gir feil svar umiddelbart, tenker 70B-varianten seg om i to minutter før den kommer med det riktige svaret. Men, nå er jo ikke en språkmodell ment å være et oppslagsverk heller!

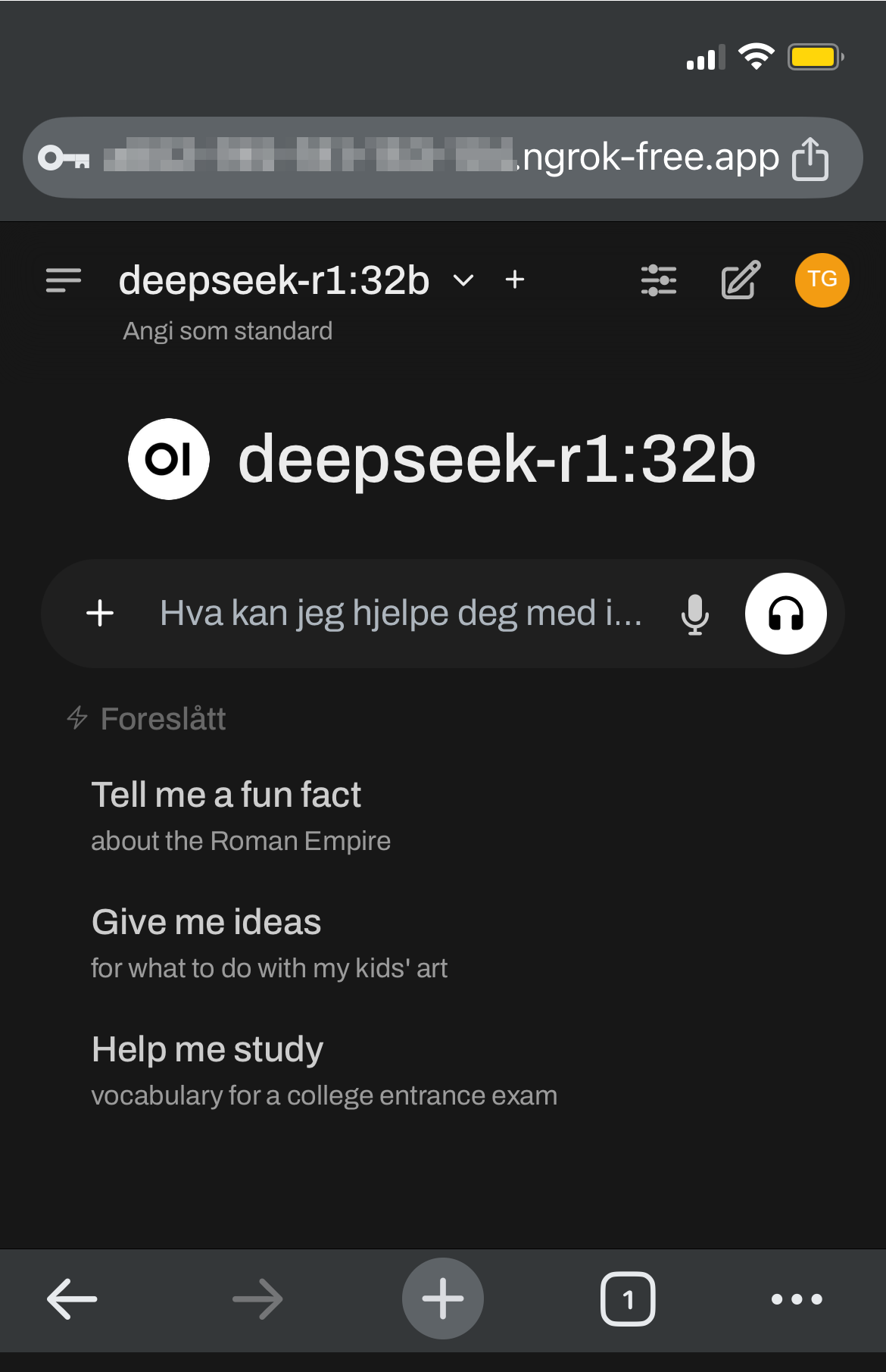

En annen fordel med å kjøre språkmodellen i nettleseren, er at du kan bruke en tjeneste som ngrok for å gjøre den tilgjengelig over internett, slik at du f.eks. kan bruke den fra mobiltelefonen.

God fornøyelse!